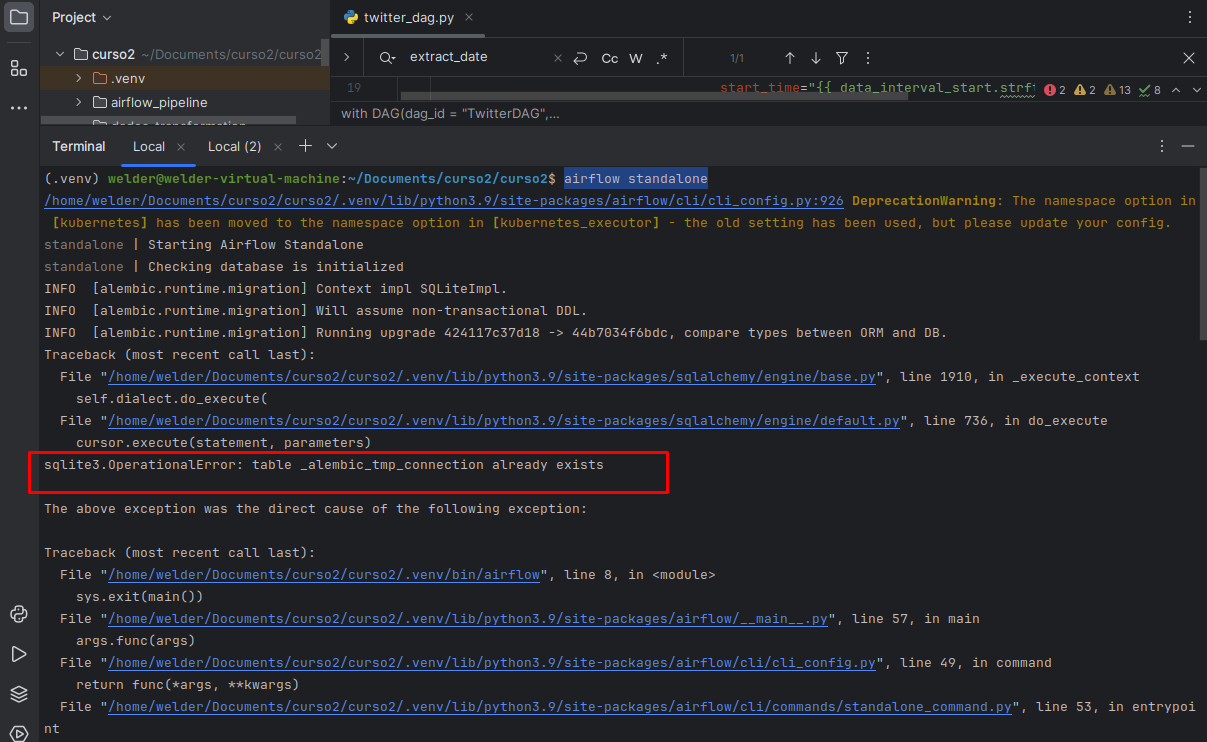

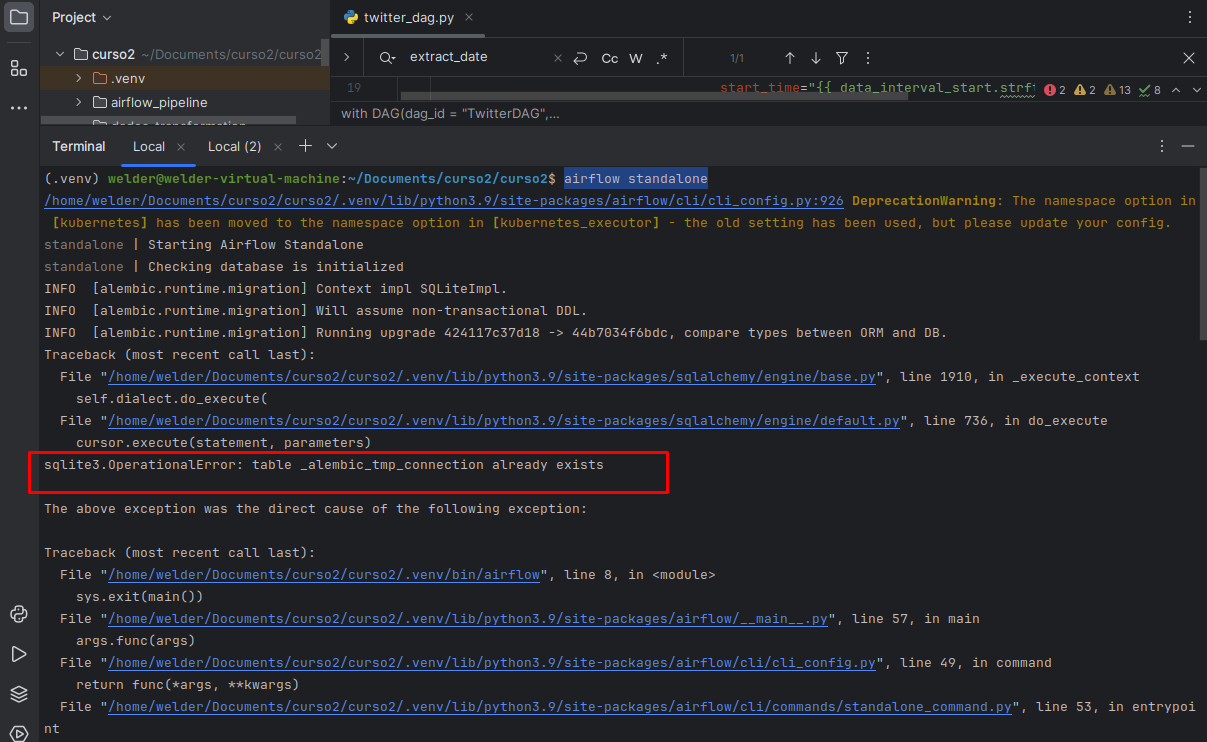

Olá, ao Rodar pela segunda vez o comando para inicializar o Airflow apresentou a mensagem que a tabela já existe.

Olá, ao Rodar pela segunda vez o comando para inicializar o Airflow apresentou a mensagem que a tabela já existe.

Resolvi com o comando airflow db reset.

Olá, Welder, tudo bem?

Que bom que conseguiu realizar o problema que estava enfrentando!

Caso surja outra dúvida, é só compartilhar no fórum.

Abraços e bons estudos!

Olá Monalisa, eu concluí o curso ontem. Porém precisava de mais autonomia para gerenciar os recursos. A Alura tem um docker-compose e Dockerfile contendo as configurações do Airflow e Spark?

Consegui encontrar um docker-compose com Airflow e Spark no Github não sendo da Alura, mas não identifica onde está o Spark-submit mesmo eu definindo a variavel no Dockerfile.

Olá Welder, tudo bem ?

Deixo aqui algumas recomendações de conteudos que podem te ajudar:

Quanto a essa situação especifica não temos um Dockerfile para te fornecer.

Mas deixo duas recomendações que podem te ajudar:

1 - A documentação do Spark sobre como funciona e como rodar o Spark em Kubernetes

2- E o que eu acho que pode mais te ajudar é esse repositório onde a pessoa explora justamente isso de Docker+Airflow+Spark criando uma DAG justamente para utilizar o Spark-Submit.

Repositorio do projeto: https://github.com/pyjaime/docker-airflow-spark

Acredito que esses conteúdos podem te ajudar a chegar no resultado que você precisa.

E agradeço por trazer esse tópico, nós da escola de dados vamos avaliar para criar um conteudo nosso sobre esse assunto que é tão legal de combinar Docker+Airflow+Spark.

Bons estudo e qualquer duvida não hesite em perguntar.

Olá Igor, boa tarde!

Ire fazer o testes nessse repo.

Irá ajudar bastante essa imagem docker quando vocês montarem, ultimamente tenho usado somente docker para montar os ambientes, porém o Spark está me gerando uma dificuldade para rodar no Airflow.

Gostei bastante do curso, a didática foi ótima que nem via o tempo passar. Terminei o curso em dois dias. Obrigado!

Olá Igor, como vai? O Repositório(https://github.com/pyjaime/docker-airflow-spark) que você indicou está com o Dockerfile bugado. Postei uma mensagem na issue, mas parece que não teve solução.

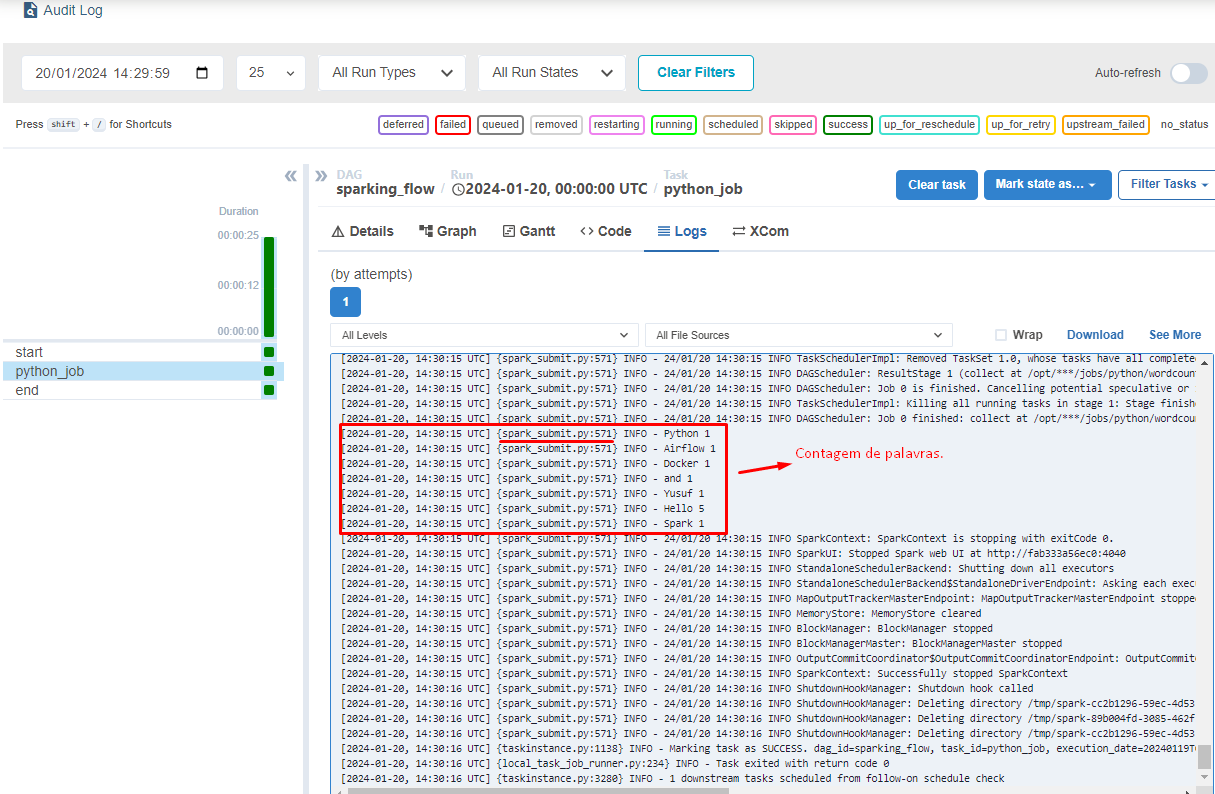

Esse repositório(https://github.com/airscholar/SparkingFlow) funcionou bem, mas por algum motivo o airflow não está conseguindo localizar o spark-submit. Seria possível você tentar replicar no seu docker para ver se acontece o mesmo caso?

att, Welder

Olá Igor, Consegui identificar o problema do spark-submit, postei na issue do repositório github a solução. Caso queria fazer o teste já está funcionando.

https://github.com/airscholar/SparkingFlow/issues/2