Trilha • Alura

Trilha • Alura

Com certificado!

Com certificado!

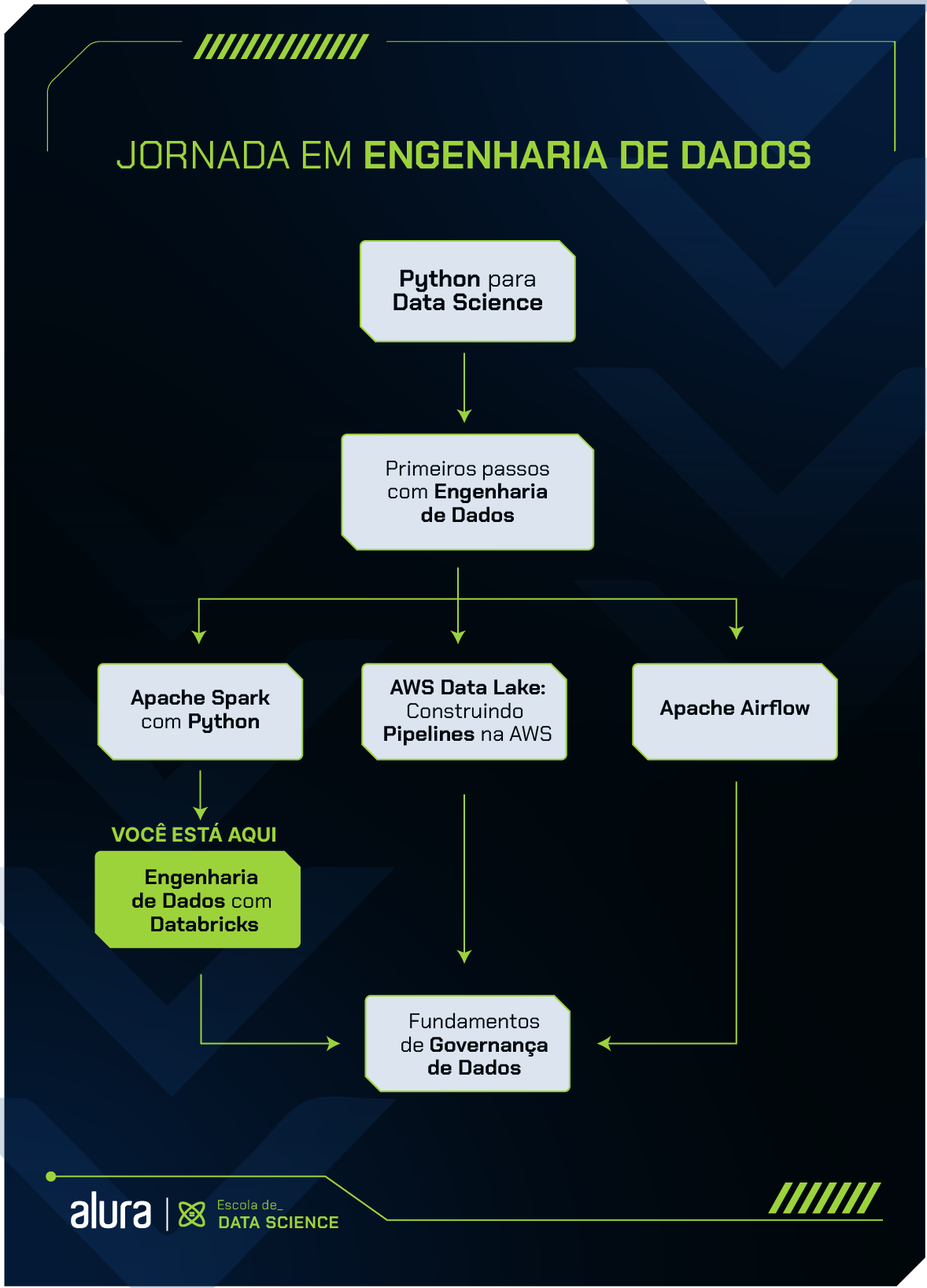

Engenharia de dados com Databricks

Para conclusão

Cursos

Artigos

Conheça a formação de Databricks

Aprenda a realizar a análise exploratória de conjuntos de dados, criar modelos de machine learning e processar grandes volumes de dados utilizando Databricks.

A formação de Databricks busca preparar estudantes para trabalhar com Ciência de Dados e Engenharia de Dados, utilizando recursos do Apache Spark e linguagens como Python e SQL.

Funciona como um guia de aprendizado para auxiliar pessoas interessadas em entrar no mercado de trabalho e também como mecanismo de consulta para profissionais experientes.

O QUE É DATABRICKS?

O Databricks é uma plataforma de computação em nuvem criada para cuidar da análise exploratória, criar modelos de machine learning e processar grandes volumes de dados de uma forma mais simples que as outras ferramentas do mercado. Essa plataforma foi desenvolvida em 2013 pelos mesmos criadores do Apache Spark.

O QUE VAMOS APRENDER?

Nesta formação, vamos conhecer a plataforma Databricks entendendo e aplicando de forma prática alguns conceitos como: análise exploratória, processamento de dados e machine learning.

Você vai aprender a manipular dados utilizando SQL, Python e Pandas. Além disso, vai trabalhar com diferentes formatos de arquivos, como: JSON, CSV, TXT, AVRO, Parquet e ORC. E também vai conhecer a biblioteca MLlib do Spark Core.

Por fim, vamos focar nossos estudos na orquestração de pipelines, integrando o Databricks com outras ferramentas de cloud para auxiliar nesse processo.

QUAIS SÃO OS PRÉ-REQUISITOS PARA FAZER ESSA FORMAÇÃO?

Para aproveitar melhor esse conteúdo, é importante que você já saiba programar em linguagem Python, tenha conhecimento em Spark e saiba conceitos básicos de SQL.

Com quem você irá aprender

📅 Planeje seus dias de estudo

Inicie a trilha organizando sua rotina de estudos, pense em sua disponibilidade e defina sua dedicação.

Passo a passo

-

1

Manipulando dados

-

2

Data Science e Machine Learning

-

3

Orquestrando pipelines de dados