Olá, Adriely! Como vai?

Agradeço por compartilhar seu código com a comunidade Alura.

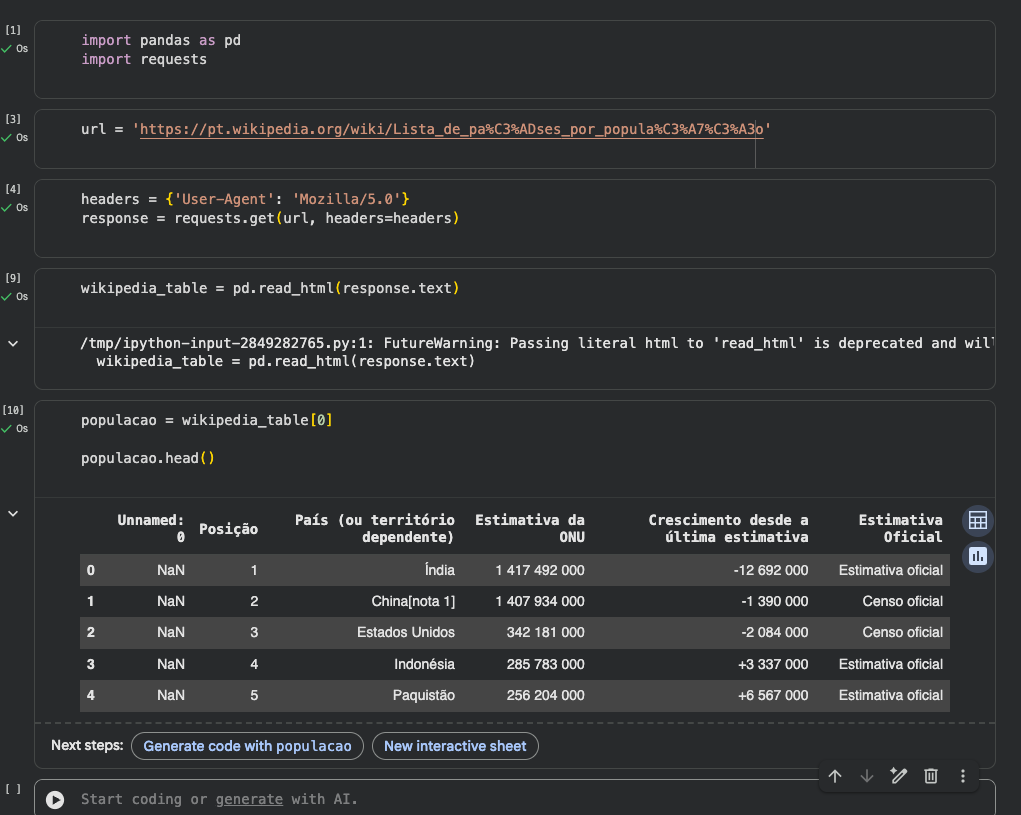

Você mostrou um ótimo entendimento do desafio! Usar requests com um User-Agent foi a escolha certa para obter o conteúdo da página antes de extrair as tabelas.

Uma dica interessante para o futuro é usar o método response.status_code para conferir se a requisição realmente funcionou. Veja este exemplo:

import requests

url = "https://exemplo.com"

resposta = requests.get(url)

print(resposta.status_code)

Esse código imprime o código de status da requisição, ajudando a identificar se a pagina foi carregada corretamente.

Qualquer dúvida que surgir, compartilhe no fórum. Abraços e bons estudos!

Conte com o apoio da comunidade Alura na sua jornada. Abraços e bons estudos!

Conte com o apoio da comunidade Alura na sua jornada. Abraços e bons estudos!