Olá, tudo bem?

Primeiramente, gostaria de falar que não achei esse curso nos filtros para adicionas as tags e não consegui abrir a dúvida pelo fórum do curso.

Link do meu notebook: https://colab.research.google.com/drive/1AuaAXgQb0enUOai-SnU1jaNSERGJSUYQ?usp=sharing

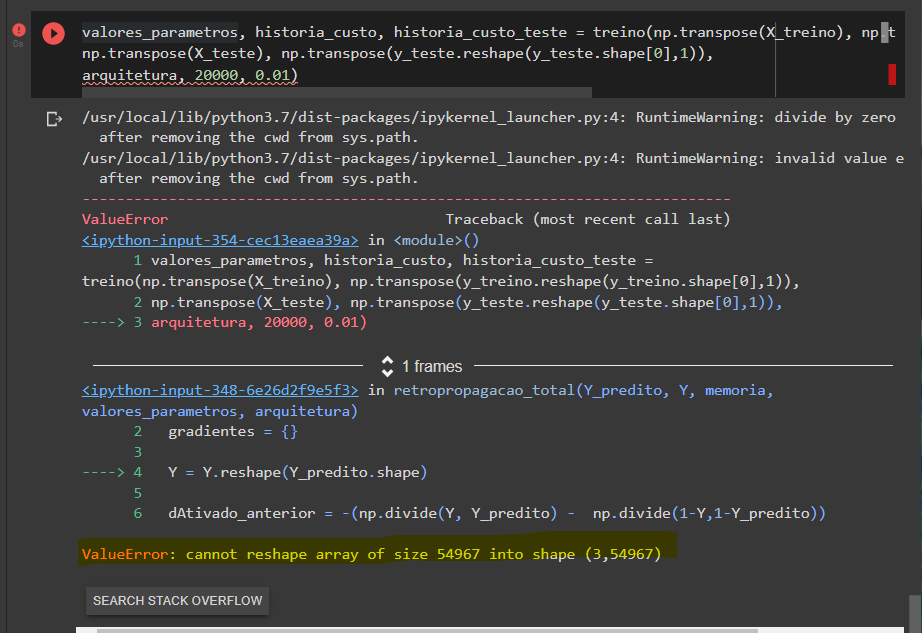

A dúvida que tenho é sobre estes 2 erros que não consigo resolver de jeito nenhum:

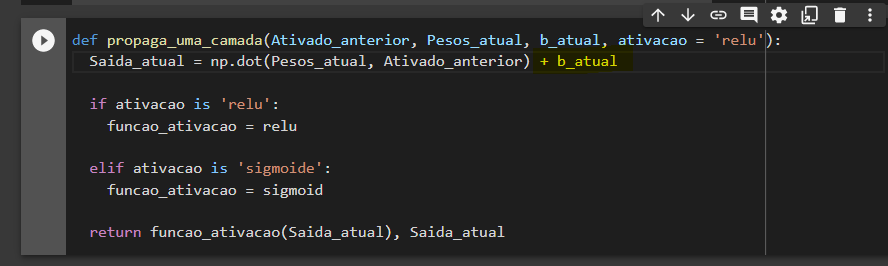

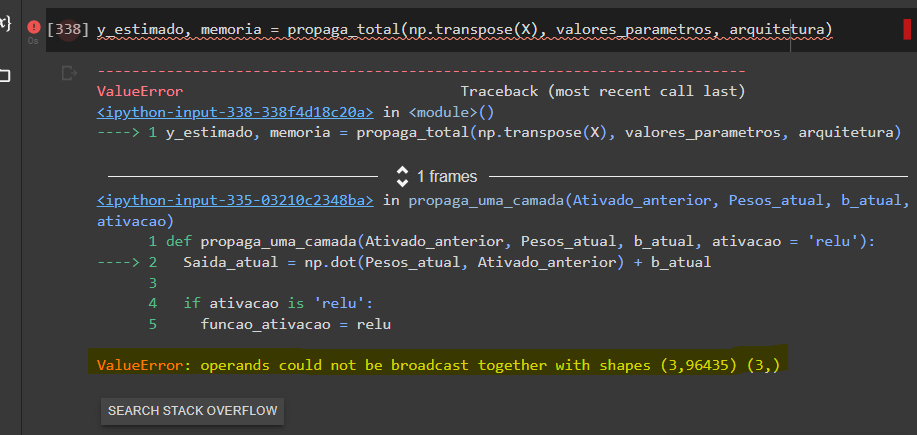

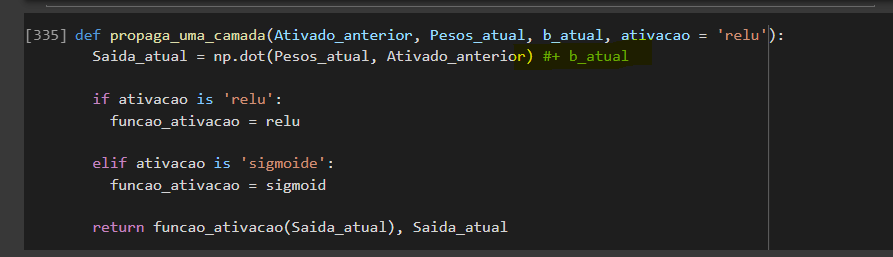

Não consigo somar o b_atual na função propaga_uma_camada e já pesquisei na documentação, já tentei um reshape, mas nada funciona. O que estou fazendo de errado e como conserto?

Quando comento '#+ b_atual' consigo rodar o código, mas obviamente não está certo fazer isso porque acredito que estou apenas ignorando o bias.

Em seguida, recebo o mesmo erro quando estou fazendo o treino, e novamente não sei o que está dando errado visto que estou usando um dataset com 3 colunas, modelando no mesmo tamanho que o curso.