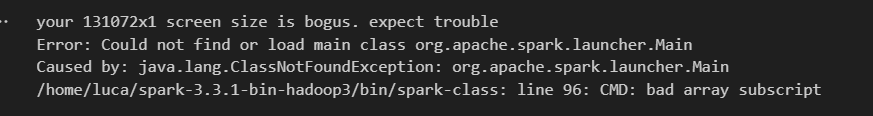

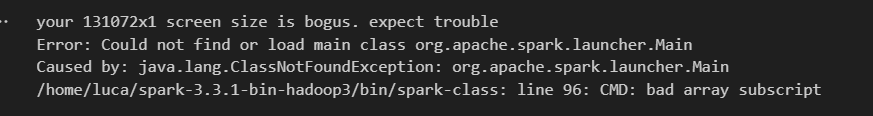

Ao tentar executar a sessão, conforme mostrado na aula, obtive este erro, como se fosse algo relacionado ao java, mesmo eu já tendo instalado no wsl. O projeto foi criado dentro do wsl, e tbm foi utilizado um ambiente virtual.

Ao tentar executar a sessão, conforme mostrado na aula, obtive este erro, como se fosse algo relacionado ao java, mesmo eu já tendo instalado no wsl. O projeto foi criado dentro do wsl, e tbm foi utilizado um ambiente virtual.

Olá Luca, tudo bem ? Espero que sim.

Desculpe a demora em responder.

A minha recomendação é baixar e instalar novamente a instalação.

É importante verificar a versão do Java instalada na sua máquina. E também instalar o PySpark via comando pip.

sudo apt-get install openjdk-8-jdk-headless -qq

java -version

!pip install pyspark==3.3.1

Instalando o Spark:

Configurando Aiflow Spark

Configurando a variavel de ambiente:

Poderia por favor tentar esses passos novamente, mas caso o erro persista me passe o comando executado e o erro completo, para juntos resolvermos isso.