Usar o parâmetro batch_size=5 em sua chamada ao método fit do modelo efetivamente significa que você está instruindo o modelo a atualizar os pesos após cada lote (ou "batch") de 5 exemplos de treinamento. A escolha do tamanho do batch tem várias implicações tanto no desempenho do treinamento quanto na qualidade do modelo treinado. Vamos discutir algumas dessas implicações:

Impacto do Tamanho do Batch

1. Convergência do Modelo:

- Batches Menores podem levar a atualizações de peso mais frequentes, o que pode ajudar o modelo a convergir mais rapidamente em termos do número de exemplos processados. No entanto, essas atualizações podem ser mais "ruidosas" ou variáveis, o que às vezes pode ser benéfico ao ajudar o modelo a sair de mínimos locais durante o treinamento.

- Batches Maiores proporcionam estimativas do gradiente mais estáveis, mas cada atualização é menos frequente. Isso pode tornar o treinamento mais estável, mas também pode exigir mais épocas para alcançar a convergência, e há um risco maior de ficar preso em mínimos locais.

2. Uso de Memória:

- Batches Menores consomem menos memória, o que é uma consideração importante se você está trabalhando com uma quantidade limitada de recursos computacionais.

- Batches Maiores podem exceder a capacidade de memória da sua GPU/CPU, levando a erros de memória ou forçando o treinamento a ser realizado em um dispositivo menos potente.

3. Qualidade do Modelo:

- A literatura mostra que há um trade-off entre a qualidade do modelo e o tamanho do batch. Batches muito grandes podem levar a uma generalização pior, enquanto batches muito pequenos podem causar instabilidade no treinamento e levar mais tempo para convergir.

O Tamanho do Batch de 5 é Bom?

A escolha de um batch_size=5 é bastante pequena e pode ser adequada para conjuntos de dados pequenos, mas para conjuntos de dados maiores, isso pode tornar o treinamento desnecessariamente longo e potencialmente instável. No entanto, se os recursos computacionais são uma limitação, ou se você está experimentando para encontrar o melhor tamanho do batch, começar com um tamanho menor pode ser uma estratégia razoável.

A regra geral é experimentar com diferentes tamanhos de batch para encontrar um equilíbrio entre a velocidade de treinamento, o uso de memória e a qualidade do modelo. Frequentemente, tamanhos de batch como 32, 64 ou 128 são um bom ponto de partida, mas a escolha ideal pode variar dependendo do seu caso específico.

Conclusão

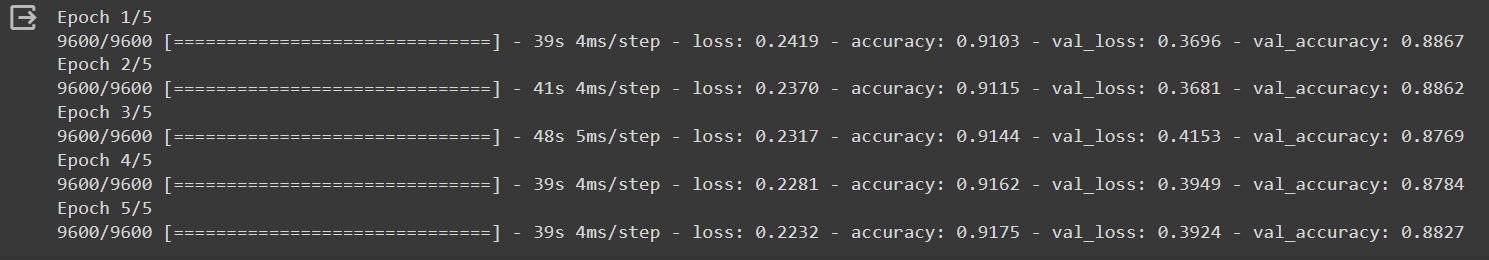

A eficácia de um batch_size=5 depende muito do seu conjunto de dados, da complexidade do modelo e dos recursos computacionais disponíveis. Monitorar o desempenho do modelo, tanto no conjunto de treinamento quanto no de validação, ajudará a determinar se esse tamanho de batch é adequado ou se ajustes são necessários para melhorar os resultados.

Gostaria de saber se os resultados são bons ou estamos prejudicando de alguma forma o nosso modelo.

Gostaria de saber se os resultados são bons ou estamos prejudicando de alguma forma o nosso modelo.