Para elaborar um cronograma de estudos, utilizei dos seguintes passos:

1) Usando o Prompt BAB simulei uma transição de carreira e pedi para o GPT fazer um planejamento de estudos para criar uma ponte entre a minha situação atual e onde quero chegar.

2) Com planejamento de estudos feito, solicitei que me ajudasse a identificar o meu nível cognitivo de conhecimento usando a taxonomia de Bloom

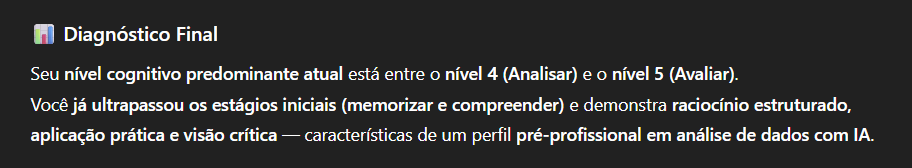

3) Com o diagnóstico da taxonomia de Bloom consegui identificar o nível cognitivo predominante atual, e o diagnóstico foi o seguinte:

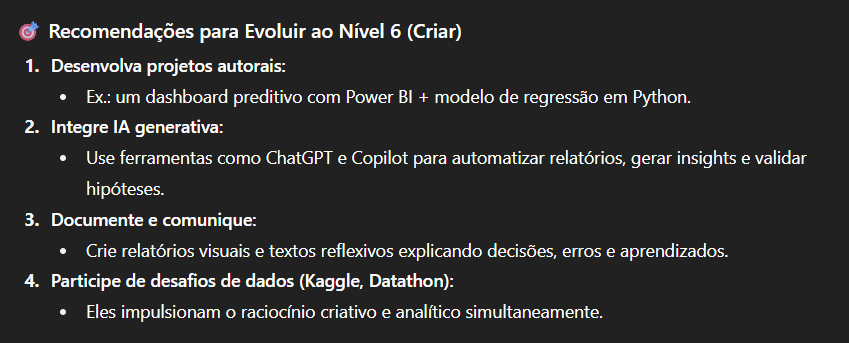

5) E deu a seguinte recomentação:

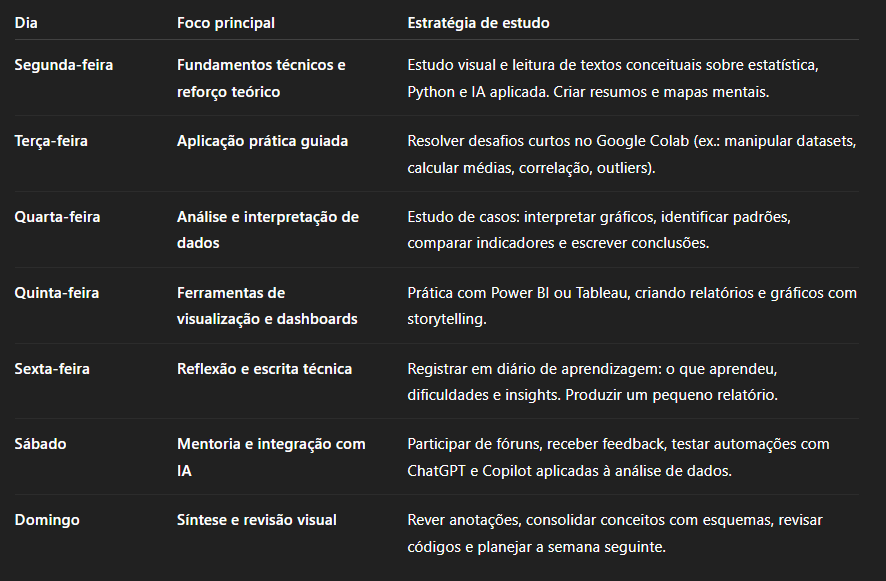

6) Baseado no diagnóstivo e na recomendação, solicitei que o GPT me ajudasse a elaborar um cronograma de estudos semanal para melhorar os níveis cognitivos que preciso desenvolver.

- O ChatGPT me retornou com a seguinte sugestão de cronograma de estudos:

Cronograma Semanal de Estudos – Evolução Cognitiva em Análise de Dados com IA

Objetivo geral:

Avançar dos níveis “Aplicar” e “Analisar” para “Avaliar” e alcançar o estágio “Criar”, desenvolvendo autonomia analítica e capacidade de elaborar projetos autorais com IA.

Duração sugerida: 12 semanas (3 meses)

Tempo médio diário: 2 horas de estudo estruturado + 1 hora opcional de prática livre ou mentoria.

Estilo de aprendizagem: Visual e leitura/escrita, com exercícios práticos e sínteses reflexivas.

1. Estrutura semanal fixa

2. Metas por ciclo de 4 semanas

Semanas 1–4 | Consolidação do nível “Aplicar”

Objetivo: Ganhar fluência técnica para manipular e transformar dados.

Conteúdos-chave:

- Revisão de Python para análise (Pandas, NumPy, Matplotlib).

- Estatística descritiva e correlação.

- Limpeza e padronização de dados.

- Criação de gráficos básicos e relatórios automáticos.

Atividades: - 3 mini projetos (ex.: controle de vendas, gastos administrativos, desempenho de equipe).

- Criação de um mapa conceitual sobre o fluxo da análise de dados.

Indicador de progresso: consegue aplicar técnicas sem depender de tutoria passo a passo.

Semanas 5–8 | Desenvolvimento do nível “Analisar”

Objetivo: Aprender a interpretar resultados e identificar padrões e causas.

Conteúdos-chave:

- Análise exploratória (EDA) em Python.

- Visualização comparativa de dados e storytelling.

- Introdução à regressão linear e modelos simples de previsão.

- Avaliação de qualidade dos dados e confiabilidade das fontes.

Atividades: - Projetos de estudo de caso com datasets reais (Kaggle, Dados.gov.br).

- Escrita de relatórios interpretativos sobre relações entre variáveis.

- Participação em fóruns para comparar análises com outros aprendizes.

Indicador de progresso: interpreta resultados com embasamento técnico e identifica possíveis causas.

Semanas 9–12 | Transição para o nível “Avaliar” e início do “Criar”

Objetivo: Desenvolver pensamento crítico e criativo, capaz de avaliar métodos e propor soluções.

Conteúdos-chave:

- Métricas de desempenho de modelos (precisão, erro, overfitting).

- Comparação entre técnicas de análise e visualização.

- Introdução à IA generativa aplicada à análise (ChatGPT, Dataiku, Power BI Copilot).

- Ética e confiabilidade na interpretação de dados.

Atividades: - Projeto autoral final: “Dashboard inteligente de previsão administrativa”, unindo Python + Power BI + IA generativa.

- Redação de relatório final avaliando métodos usados e melhorias futuras.

- Apresentação visual (vídeo ou slides) explicando insights e decisões.

Indicador de progresso: toma decisões embasadas, avalia modelos e propõe soluções criativas.

3. Recursos recomendados

- Visuais: vídeos e tutoriais no YouTube (Data Science do Zero, Hashtag Programação).

- Leitura/escrita: livros Python para Análise de Dados (Wes McKinney) e Storytelling com Dados (Cole Nussbaumer).

- Prática: Kaggle, Google Colab, Power BI e Tableau.

- Mentoria: comunidades como DataHackers e LinkedIn Learning Groups.

4. Avaliação contínua

Ao final de cada semana, registrar:

- O que aprendi (conceitos e práticas).

- Onde tive dificuldade e como resolvi.

- O que aplicarei em um mini projeto.

Ao concluir o ciclo de 12 semanas, você terá evoluído dos níveis “Aplicar/Analisar” para “Avaliar”, construindo a base para “Criar” — produzindo soluções originais com análise de dados e IA integrada.