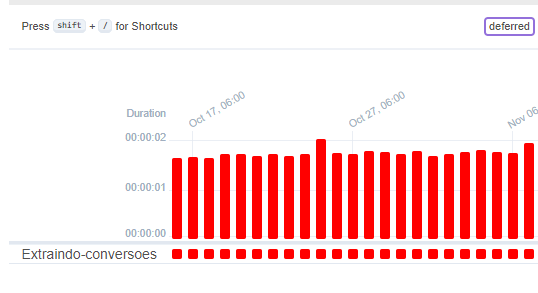

Bom Dia! Segui passo a passo toda estrutura de ambiente e criação da dag, porém ao habilita-la no ariflow esta apresentando falha.

# Databricks notebook source

from airflow import DAG

from airflow.providers.databricks.operators.databricks import DatabricksRunNowOperator

from datetime import datetime

with DAG(

'Executando-notebook-etl',

start_date=datetime(2023, 9, 6),

schedule_interval="0 9 * * *"

) as dag_executando_notebook_extracao:

extraindo_dados = DatabricksRunNowOperator(

task_id='Extraindo-conversoes',

databricks_conn_id='databricks_default',

job_id=51568654875,

notebook_params={

"data_execucao": '{{data_interval_end.strftime("%Y-%m-%d)}}'}

)

extraindo_dados

Algúem passou por isso? Alguma sugestão.

Obrigado!