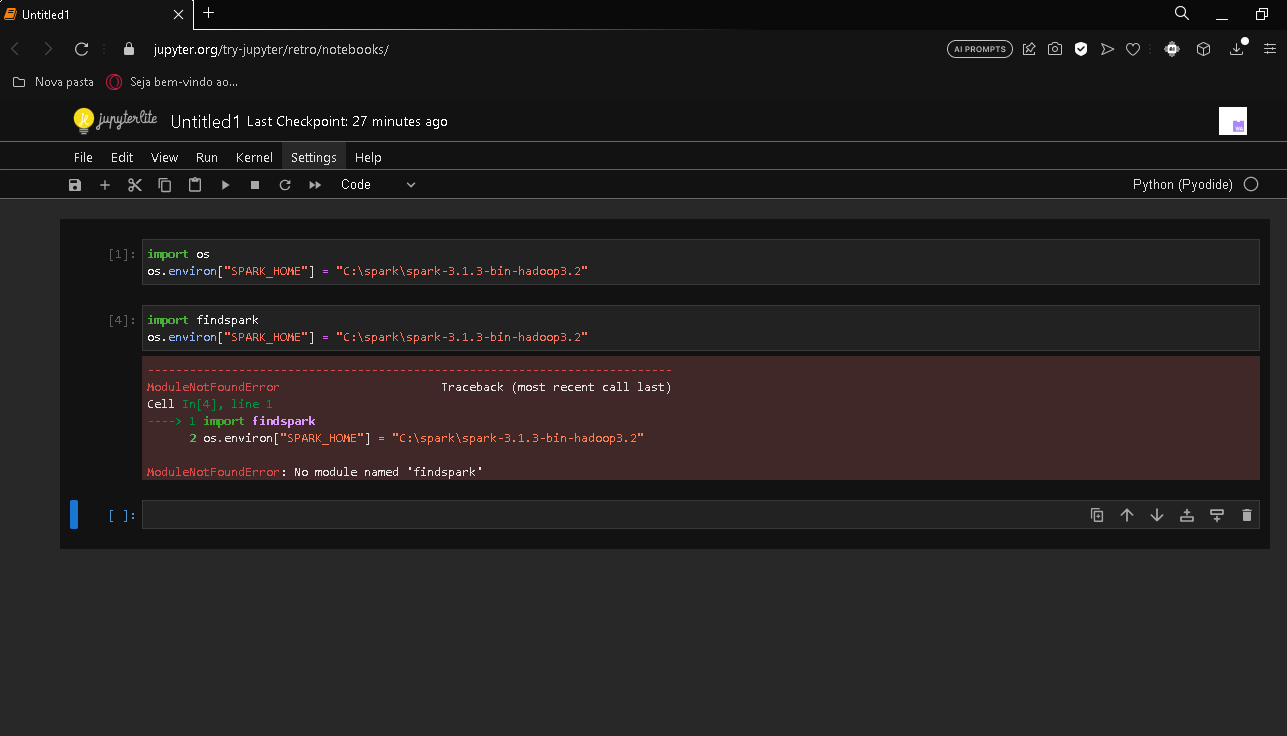

Na aula "Utilizando Spark no Windows" foi passada uma série de informações e links para que pudéssemos rodar o spark e começar com o curso. Por mais que ficaram muitas duvidas na explicação do professor Rodrigo Dias, ainda assim, segui passo a passo do que foi orientado. Porem, não tive sucesso na etapa onde importamos o findspark no novo notebook criado.

Não sei dizer onde pode estar a falha. Pode ser que seja a versão do meu spark, já que a versão apresentada na aula não está mais disponível para download; Pode ser alguma falha no processo de instalação do findspark no CMD, ou uma falha da ativação por parte do meu python 3.11.4; Pode ser que seja a versão do winutils, uma vez que não existe uma versão compatível com o spark que estou usando; Pode ser o link que estou utilizando do Jupyter, já que não acessei pelo anaconda. (Caso seja necessário acessar pelo anaconda, gostaria de uma orientação de como chegar ao exato ponto onde o professor chegou)

Gostaria muito de fazer todo o curso fazendo todo o processo junto com os instrutores, pelo preço que é pago esse é o mínimo que posso desejar. No momento, sem as orientações e ajudas, estou apenas fazendo o curso para retirar a certificação, coisa que definitivamente não gostaria de fazer.

Segue evidencia do erro: