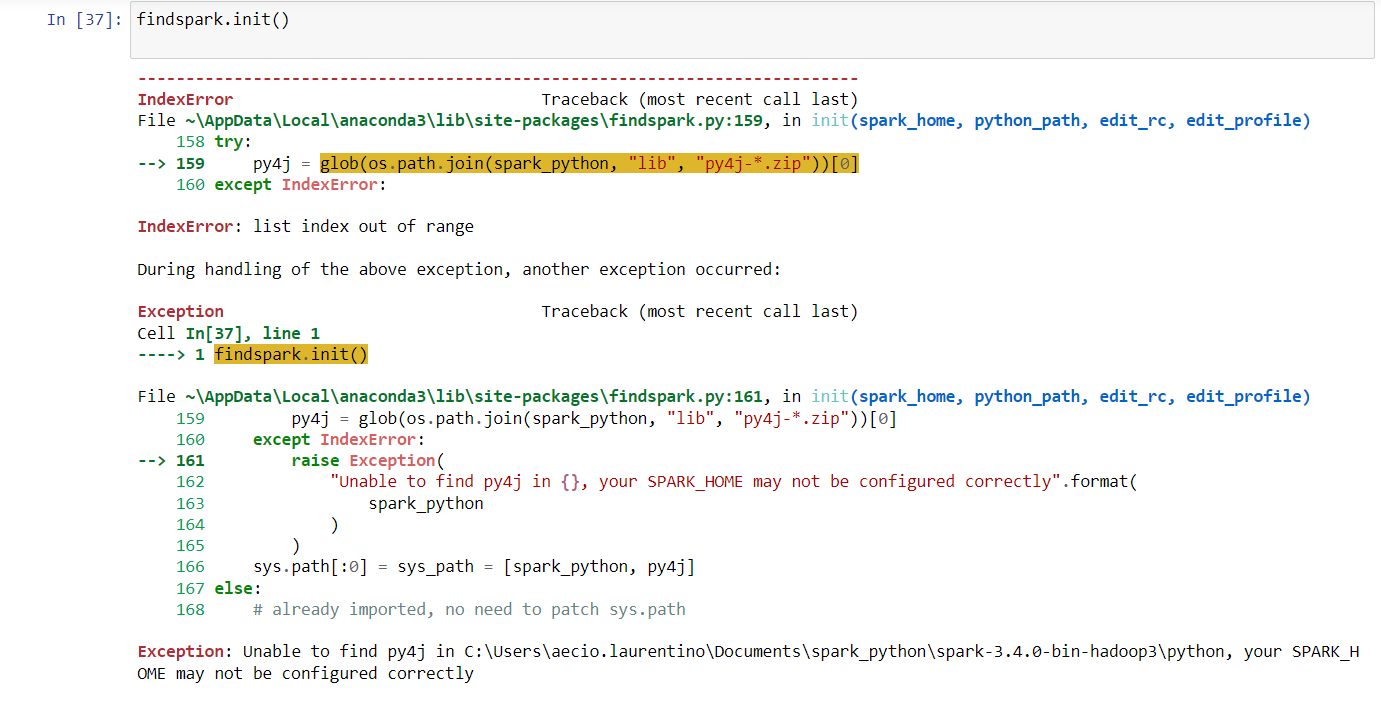

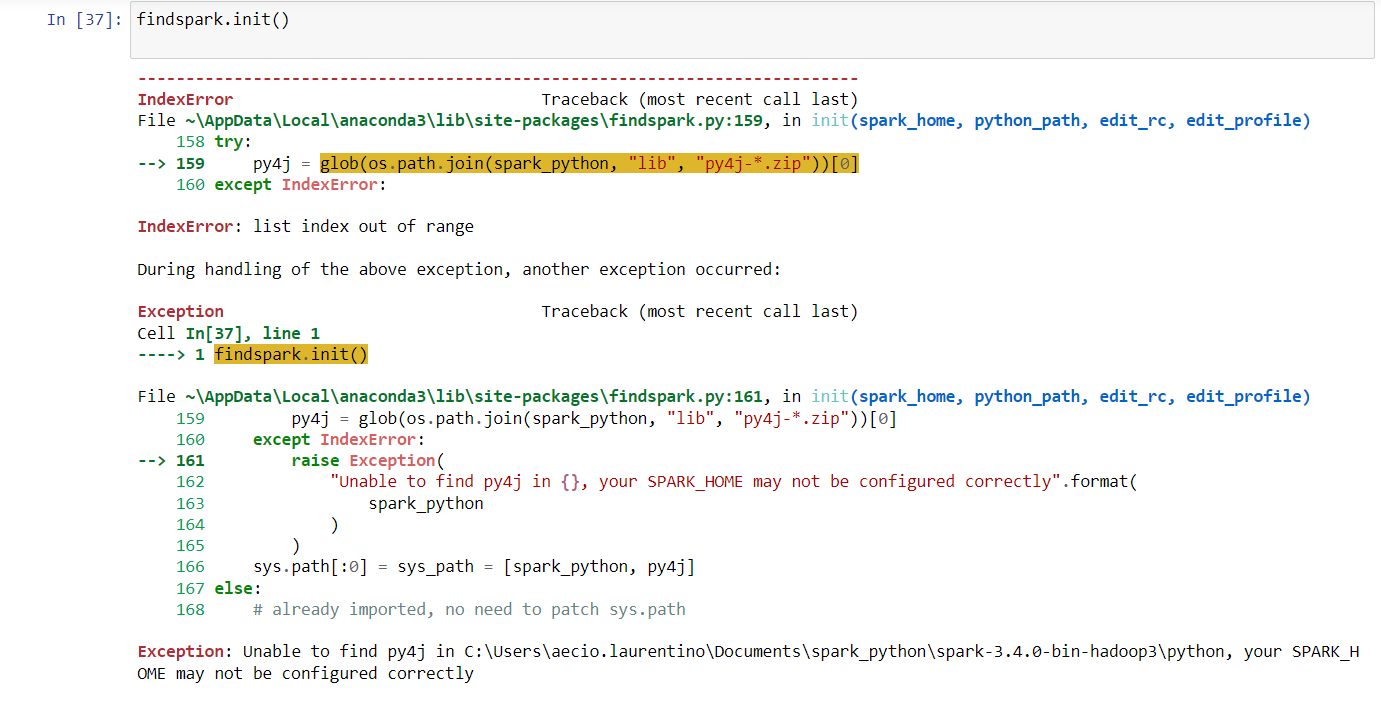

Conseugui importar o findspark porem ao tentar usar o init() da erro

Conseugui importar o findspark porem ao tentar usar o init() da erro

Olá Aécio, tudo bem com você?

Peço desculpas pela demora em obter um retorno.

Esse erro geralmente ocorre quando a variável SPARK_HOME não está configurada corretamente, seja por caminho inválido, falta de arquivos, dentre outros. Um adendo importante são as versões das ferramentas utilizadas no curso:

| Ferramenta | Versão |

|---|---|

| Spark | 3.1.2 |

| Hadoop | 2.7 |

Vale ressaltar também que versões mais recentes do Python, como a 3.11, por exemplo, pode ter problemas de incompatibilidade com o Spark, então, caso em seu ambiente local esteja utilizando o Python mais recente, peço que faça o downgrade para a versão 3.8, por exemplo.

Todavia, uma alternativa é usar o Google Colab, digitando as seguintes células:

# instalar as dependências

!apt-get update -qq

!apt-get install openjdk-8-jdk-headless -qq > /dev/null

!wget -q https://archive.apache.org/dist/spark/spark-3.1.2/spark-3.1.2-bin-hadoop2.7.tgz

!tar xf spark-3.1.2-bin-hadoop2.7.tgz

!pip install -q findspark

import os

os.environ["JAVA_HOME"] = "/usr/lib/jvm/java-8-openjdk-amd64"

os.environ["SPARK_HOME"] = "/content/spark-3.1.2-bin-hadoop2.7"

import findspark

findspark.init()

Espero ter ajudado. Continue mergulhando em conhecimento e não hesite em voltar ao fórum para continuar aprendendo e interagindo com a comunidade.

Em caso de dúvidas estou à disposição.

Abraços e bons estudos!