Ao executar: python3.13.exe -m pip install "openai>=1.0.0" tive como retorno:

ERROR: Exception:

Traceback (most recent call last):

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13_qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip_vendor\packaging\markers.py", line 280, in init

self._markers = _normalize_extra_values(_parse_marker(marker))

* ~~~~~~~~~~~~~^^^^^^^^

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\vendor\packaging\parser.py", line 253, in parsemarker

return parsefullmarker(Tokenizer(source, rules=DEFAULTRULES))

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\vendor\packaging\parser.py", line 257, in parsefullmarker

retval = parsemarker(tokenizer)

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\vendor\packaging\parser.py", line 266, in parsemarker

expression = [parsemarkeratom(tokenizer)]

~~~~~~~~~~~~~~~~~~^^^^^^^^^^^

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\vendor\packaging\parser.py", line 291, in parsemarkeratom

marker = parsemarkeritem(tokenizer)

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\vendor\packaging\parser.py", line 301, in parsemarkeritem

markervarleft = parsemarkervar(tokenizer)

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\vendor\packaging\parser.py", line 319, in parsemarkervar

tokenizer.raisesyntaxerror(

~~~~~~~~~~~~~~~~~~~~~~~~~~~~^

message="Expected a marker variable or quoted string"

^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

)

^

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\vendor\packaging\tokenizer.py", line 168, in raisesyntaxerror

raise ParserSyntaxError(

...<3 lines>...

)

pip.vendor.packaging.tokenizer.ParserSyntaxError: Expected a marker variable or quoted string

=1.0.0

^

The above exception was the direct cause of the following exception:

Traceback (most recent call last):

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\internal\cli\basecommand.py", line 107, in runwrapper

status = innerrun()

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\internal\cli\basecommand.py", line 98, in innerrun

return self.run(options, args)

~~~~~~~~^^^^^^^^^^^^^^^

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\internal\cli\reqcommand.py", line 85, in wrapper

return func(self, options, args)

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\internal\commands\install.py", line 354, in run

reqs = self.getrequirements(args, options, finder, session)

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\internal\cli\reqcommand.py", line 264, in getrequirements

reqtoadd = installreqfromline(

req,

...<3 lines>...

configsettings=getattr(options, "configsettings", None),

)

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\internal\req\constructors.py", line 427, in installreqfromline

parts = parsereqfromline(name, linesource)

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\internal\req\constructors.py", line 342, in parsereqfromline

markers = Marker(markersasstring)

File "C:\Users\User\AppData\Local\Packages\PythonSoftwareFoundation.Python.3.13qbz5n2kfra8p0\LocalCache\local-packages\Python313\site-packages\pip\vendor\packaging\markers.py", line 298, in init

raise InvalidMarker(str(e)) from e

pip.vendor.packaging.markers.InvalidMarker: Expected a marker variable or quoted string

=1.0.0

^*

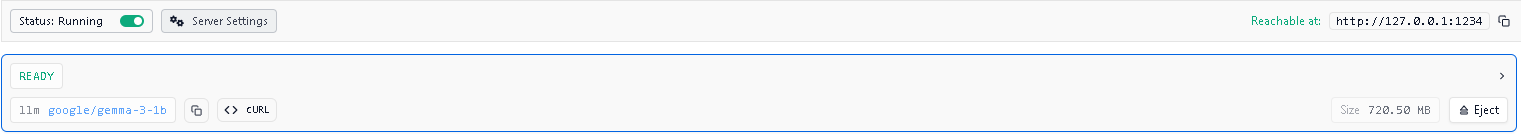

A imagem mostra que o modelo Gemma-3-!B está pronto, mas não consegui executar o script em Python mesmo tendo instalado o openai

A imagem mostra que o modelo Gemma-3-!B está pronto, mas não consegui executar o script em Python mesmo tendo instalado o openai