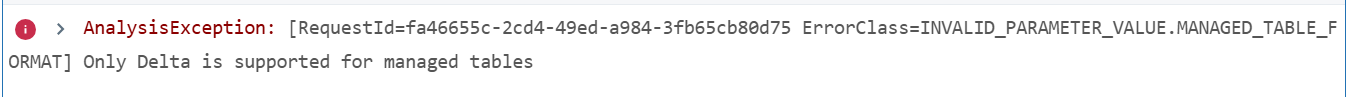

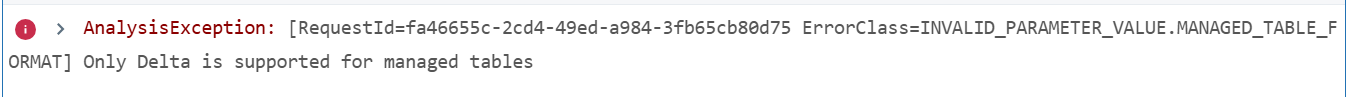

Está muito difícil acompanhar o curso, pois nada funciona mais. Não consigo criar mais o servidor (simplesmente não roda) e se eu uso o "Serverless" que já vem, também me dá o erro acima.

Está muito difícil acompanhar o curso, pois nada funciona mais. Não consigo criar mais o servidor (simplesmente não roda) e se eu uso o "Serverless" que já vem, também me dá o erro acima.

Ei, João! Tudo bem?

Agradeço por aguardar o nosso retorno.

Sobre esse erro neste formato, do Serveless, é que as tabelas gerenciadas no Databricks requerem o formato Delta e não Parquet.

Uma sugestão para a solução é substituir o seu código para:

dbutils.fs.rm('/user/hive/warehouse/data_csv', recurse=True)

file_location = '/FileStore/tables/data.csv'

file_type = 'csv'

infer_schema = 'true'

first_row_is_header = 'true'

delimiter = ';'

df = spark\

.read\

.format(file_type)\

.option('inferSchema', infer_schema)\

.option('header', first_row_is_header)\

.option('sep', delimiter)\

.load(file_location)

table_name = 'data_csv'

df.write.format('delta').saveAsTable(table_name)

A substituição foi feita em df.write.format('delta').saveAsTable(table_name) para que a tabela que será criada seja no formato Delta que é suportado.

Se sentir confortável, compartilhe como está preenchendo os dados para criar o servidor e o erro que está recebendo ao rodar, que não seja essa que escolheu do Serverless. Esse guia vai te ajudar a trazer os detalhes

Conte sempre com a nossa ajuda aqui no fórum.

Espero ter ajudado e qualquer dúvida, compartilhe no fórum.

Até mais, João!

Caso este post tenha lhe ajudado, por favor, marcar como solucionado!