Após ter criadoos arquivos e pastas solicitadas como o professor no vídeo, o DAG "twitter_dag" não aparece na GUI. Provavelmente este erro seja devido a versão que utilizo em comparação à versão que o professor utiliza no vídeo.

Para solucionar tentei matando os processos, ativando o ambiente virtual, detando a variável de ambiente e executando o servidor e o scheduler tal e como o professor realiza, mas sem sucesso.

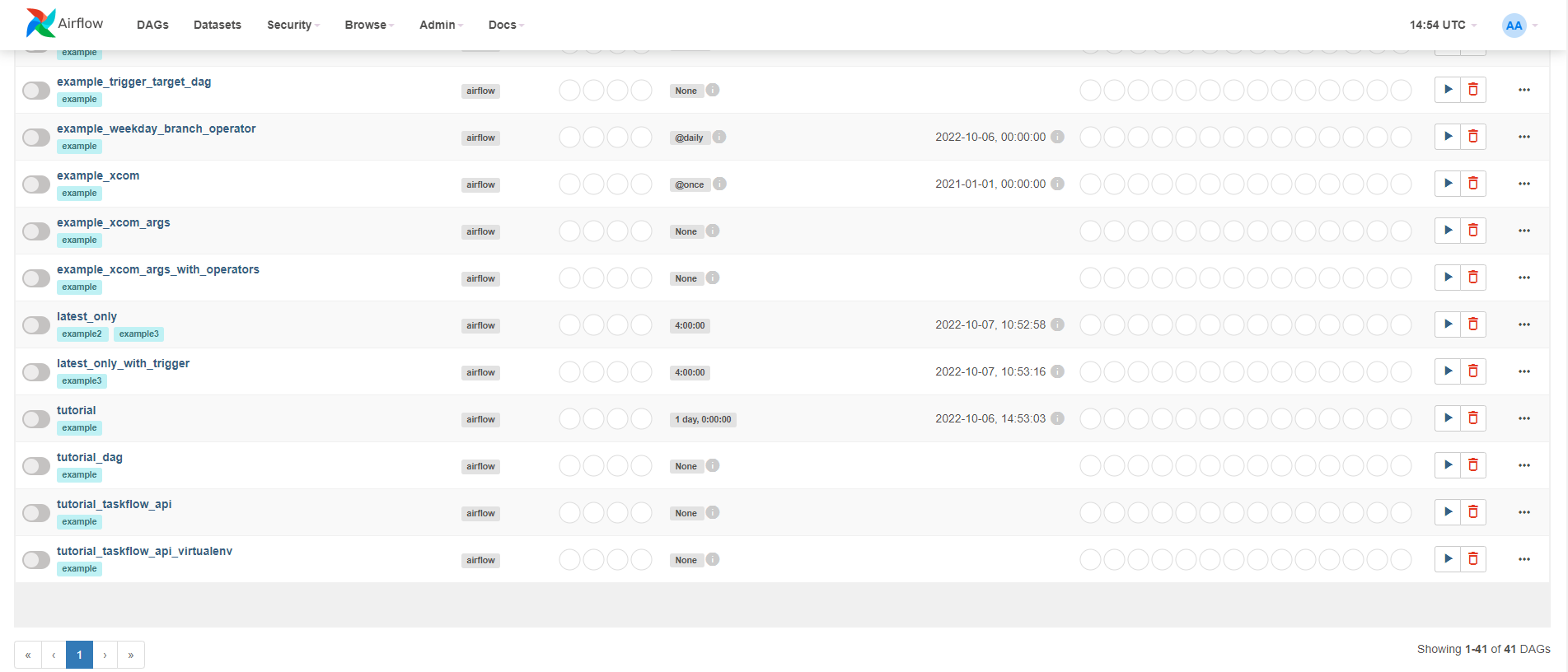

Segue print do final da lista dos DAGs:

Segue o meu código do arquivo twitter_dag.py

from airflow.models import DAG

from airflow.operators.alura import TwitterOperator

from datetime import datetime

from os.path import join

with DAG(dag_id= "twitter_dag", start_date= datetime.now()) as dag:

twitter_operator = TwitterOperator(

task_id= 'twitter_aluraonline',

query='aluraOnline',

file_path= join(

"/home/teddy/NTConsult-Codes/Curso Engenharia de Dados/Engenharia de Dados/Getting to know Apache Airflow/datapipeline/datalake", # Criando diretorio

"twitter_aluraonline", # Tabela dentro do nosso "data lake"

"extract_date={{ ds }}", # Partição dentro da tabela com a data de extração

"AluraOnline_{{ ds_nodash}}.json"

)

)Segue o código do meu arquivo airflow_plugin.py:

from airflow.plugins_manager import AirflowPlugin

from operators.twitter_operator import TwitterOperator

class AluraAirflowPlugin(AirflowPlugin):

name= "Alura"

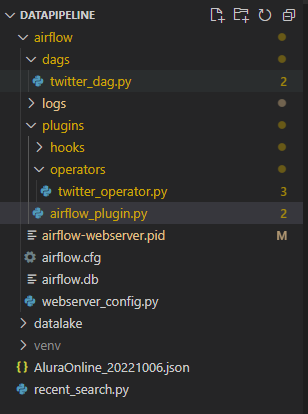

operators= [TwitterOperator]No meu projeto tenho a seguinte estrutura de arquivos:

Estou utilizando airflow versão 2.4.1