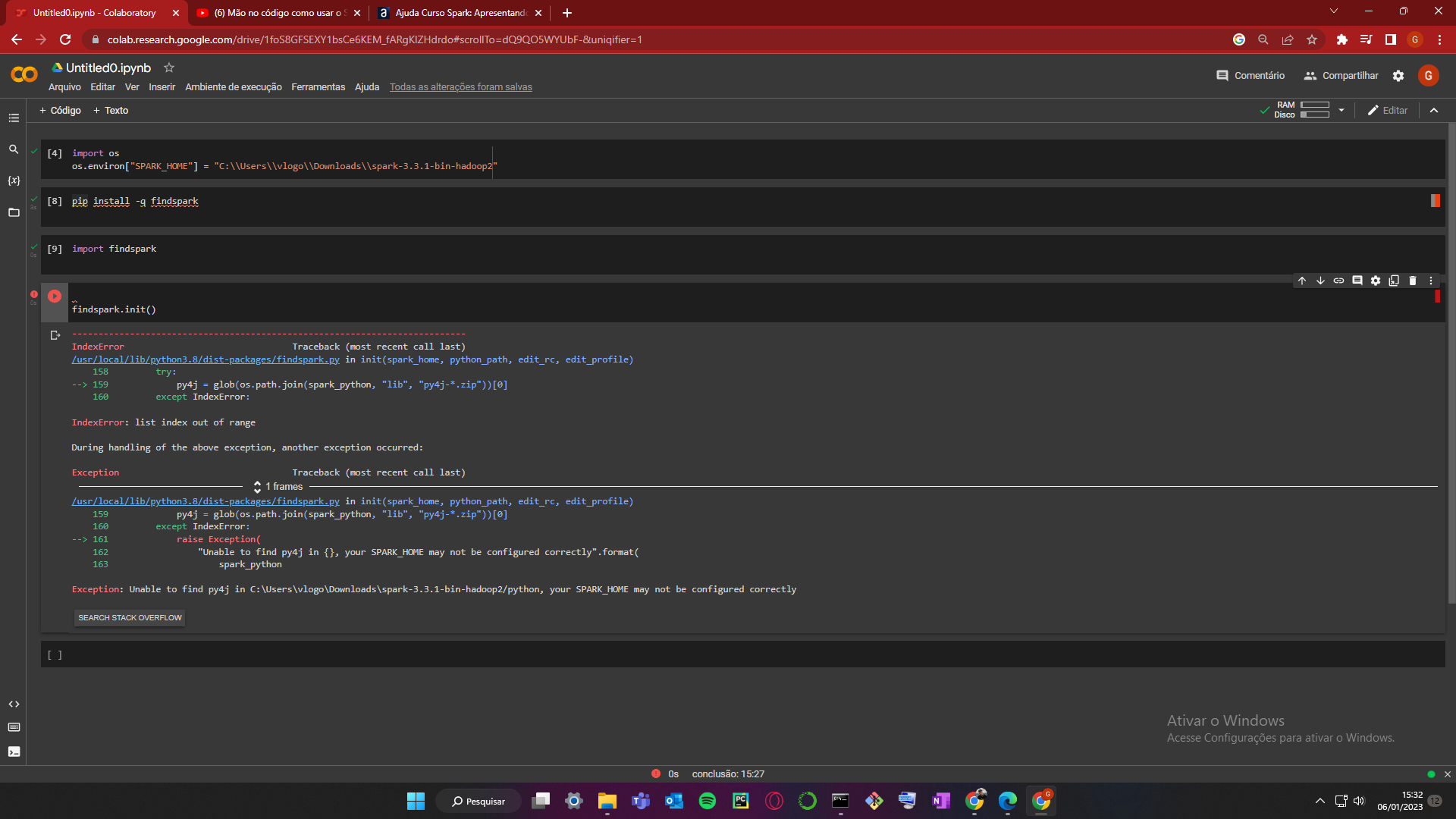

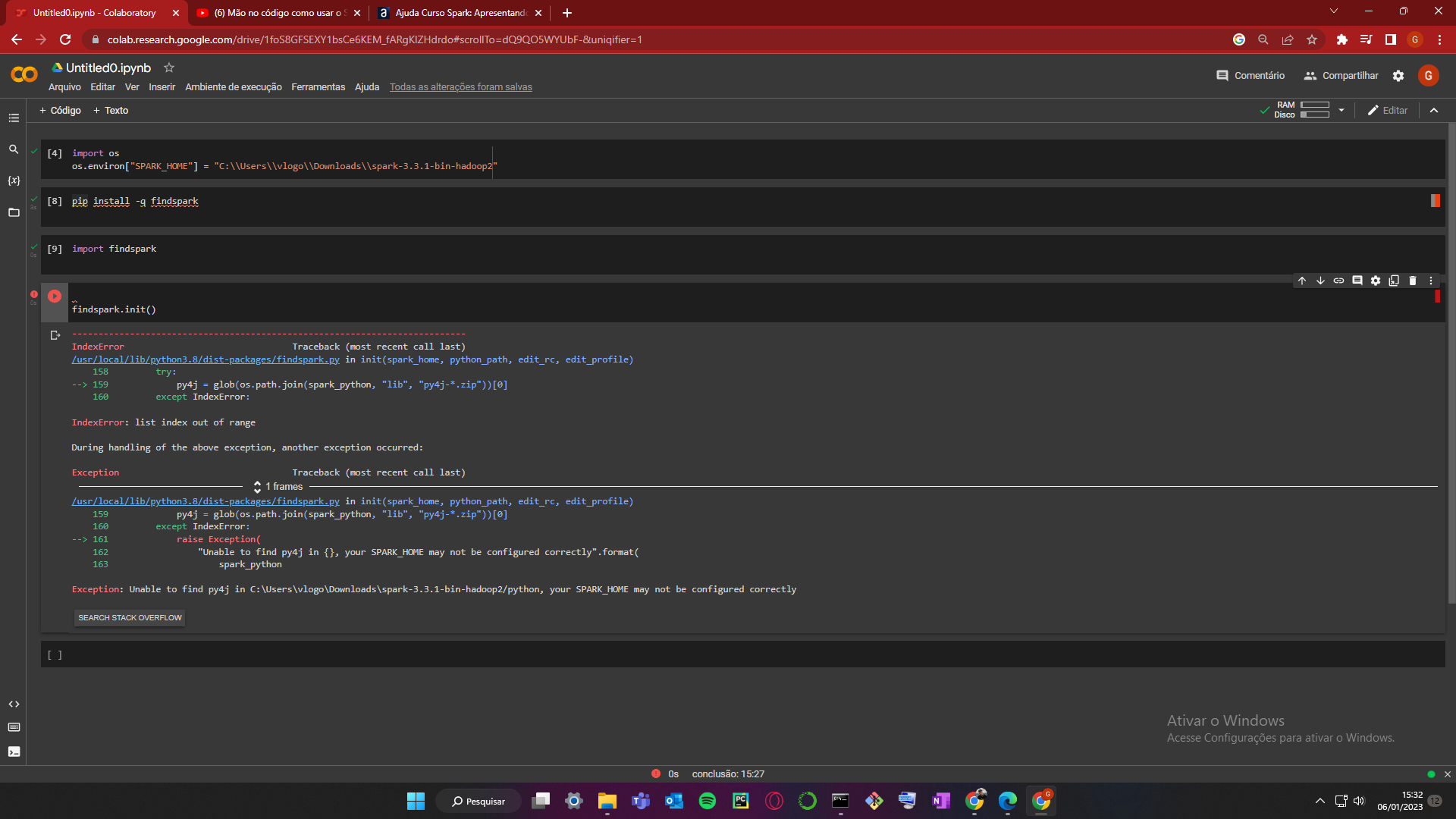

não consigo compreender o erro, a biblioteca foi baixada com sucesso, o import deu certo, mas na hora de dar init na classe da esse erro

Olá Victor, tudo bem com você?

Peço desculpas pela demora em obter um retorno.

O erro apresentado está informando que a variável de ambiente SPARK_HOME não foi configurada corretamente. Quando estamos trabalhando com o findspark no Google Colab, o caminho informado para a variável de ambientes deve ser o caminho relativo ao Google Colab. Também é necessário ter instalado o Java e o findspark no notebook do Google Colab.

Peço que realize uma nova tentativa de configuração e instalação do findspark, para isso basta seguir os passos apresentados abaixo:

Abra seu notebook do Google Colab.

Na parte superior da tela clique em "Inserir" e no menu suspenso que será aberto, clique em "Célula de código".

Na nova célula, cole o código abaixo:

# instalar as dependências

!apt-get update -qq

!apt-get install openjdk-8-jdk-headless -qq > /dev/null

!wget -q https://archive.apache.org/dist/spark/spark-3.1.2/spark-3.1.2-bin-hadoop2.7.tgz

!tar xf spark-3.1.2-bin-hadoop2.7.tgz

!pip install -q findspark

Execute a célula criada. Pressione "SHIFT" + "ENTER" para executar e criar uma nova célula.

Na nova célula, cole o código abaixo:

import os

os.environ["JAVA_HOME"] = "/usr/lib/jvm/java-8-openjdk-amd64"

os.environ["SPARK_HOME"] = "/content/spark-3.1.2-bin-hadoop2.7"

Execute a célula criada. Pressione "SHIFT" + "ENTER" para executar e criar uma nova célula.

Na nova célula, cole o código abaixo:

import findspark

findspark.init()

Execute a célula criada. Pressione "SHIFT" + "ENTER" para executar e criar uma nova célula.

Neste momento basta dar continuidade na atividade Spark no Google Colab a partir do minuto 4:40.

Espero ter ajudado. Continue mergulhando em conhecimento e não hesite em voltar ao fórum para continuar aprendendo e interagindo com a comunidade.

Em caso de dúvidas estou à disposição.

Abraços e bons estudos!