Oii Francisco, tudo bem com você?

Peço desculpas pela demora em dar um retorno.

Esses dois erros estão indicando que o findspark e o pyspark não foram encontrados.

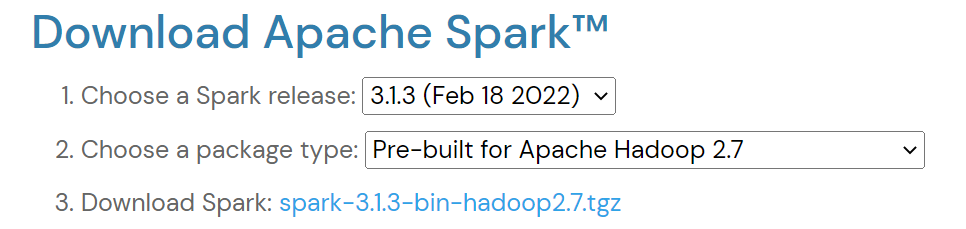

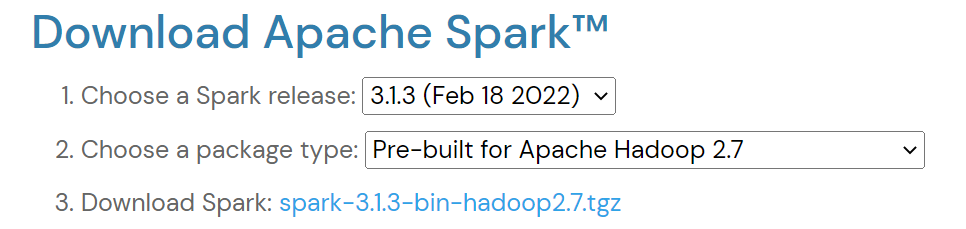

Para começar é importante que você baixe o spark seguindo todo o passo a passo mostrado pelo instrutor nos minutos iniciais desta aula. Caso a versão do spark utilizada pelo professor não esteja mais disponível, você pode baixar a seguinte versão:

Com o Spark baixado, você deve extrair ele em alguma pasta de preferência.

No vídeo o instrutor criou uma pasta chamada "spark" no diretório raiz "C:" e extraiu o spark dentro dessa pasta, dessa forma, o diretório para encontrar o spark na máquina do instrutor ficou da seguinte forma: "C:\spark\spark-3.1.2-bin-hadoop2.7".

Sugiro que você também crie essa pasta "spark" no seu diretório raiz e extraia o arquivo spark que você baixou dentro dela, dessa forma, seu diretório para acessar o spark deve ficar semelhante a: "C:\spark\spark-3.1.3-bin-hadoop2.7".

Feito isso, para tentar resolver os erros que estão acontecendo, vou te pedir que execute o seguinte comando de instalação em uma célula do seu Jupyter Notebook:

!pip install findspark

Agora você deve definir a variável de ambiente SPARK_HOME com o diretório onde você extraiu o arquivo spark baixado anteriormente. Para fazer isso, você precisará utilizar a biblioteca os da seguinte maneira:

import os

os.environ['SPARK_HOME'] = "C:\spark\spark-3.1.3-bin-hadoop2.7"

Com essa variável de ambiente definida você pode executar novamente as células de importação do findspark e do pyspark:

import findspark

findspark.init()

from pyspark.sql import SparkSession

E prontinho, acredito que isso deve resolver os erros que estavam sendo gerados :)

No decorrer das próximas aulas, o instrutor vai utilizar o Google Colab que também é um notebook, mas que roda na máquina virtual do Google e é um pouco mais simples de ser configurado. Caso você queira, também pode utilizá-lo para fazer o curso. No vídeo Spark no Google Colab o instrutor ensina certinho como você pode configurar o Google Colab para fazer o curso também.

Se o erro persistir ou tiver alguma dúvida, estou à disposição para ajudar ^^

Caso este post tenha lhe ajudado, por favor, marcar como solucionado ✓. Bons Estudos!