Ao fazer 0.1 + 0.2 = 0.30000000000000004. Até aí tudo bem, eu entendi porque esse erro acontece. Porém ficaram muitas dúvidas em relação aos números em geral. É loucura pensar que até então tudo se baseia em 10 dígitos contando com o zero. Porem é algo muito interessante e passa desapercebido por quase todos

Não sei se conseguirei me expressar em relação as minhas dúvidas...

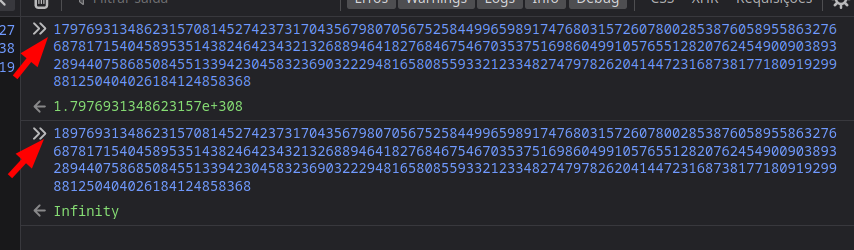

1º Os números tem um limite na computação, até porque não tem como armazenar um número infinito. Mas, se por acaso, pudéssemos conseguir armazenar números extremamente gigantescos somente com uma simples equação?

Por Exemplo: Em um banco de dados, números são armazenados dia-pós-dia, mas o que eles tem de diferença? No caso, as informações de cada um especificamente. Então, cada número em específico ocupa uma posição na memória? Por que não unificar o valor fora desses números em um só?

2º A complexidade de um número está além de seu valor. Os números constroem, destroem, modificam, criam e armazenam informações.

O quão complexo os números podem ser? Existe algum estudo mais aprofundado sobre isso?

3º Por último; Os computadores estão sempre evoluindo cada vez mais, tornando possível realizar coisas absurdas e incríveis. Seria possível em um futuro mais distante, as máquinas conseguirem se aproximar mais do programador? Até então, somos nós que tentamos estar mais perto dela, com as linguagens de baixo e alto nível. A velocidade depende apenas dos números? Entradas e saídas também?